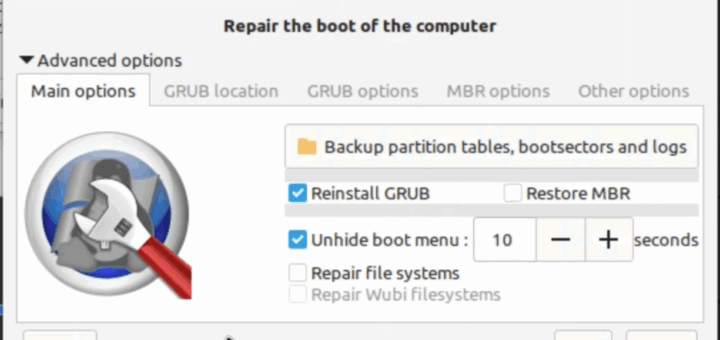

Boot Repair Tool unter Ubuntu bzw. Linux Mint

Wer kennt es nicht? Man installiert ein neues Betriebssystem, spielt an den Partitionen herum oder aktualisiert das System, und plötzlich bootet nichts mehr. Der Bildschirm bleibt schwarz, Fehlermeldungen erscheinen oder Windows startet immer wieder,...

Neueste Kommentare